Nvidia ra chip AI nhanh hơn chục lần thế hệ cũ

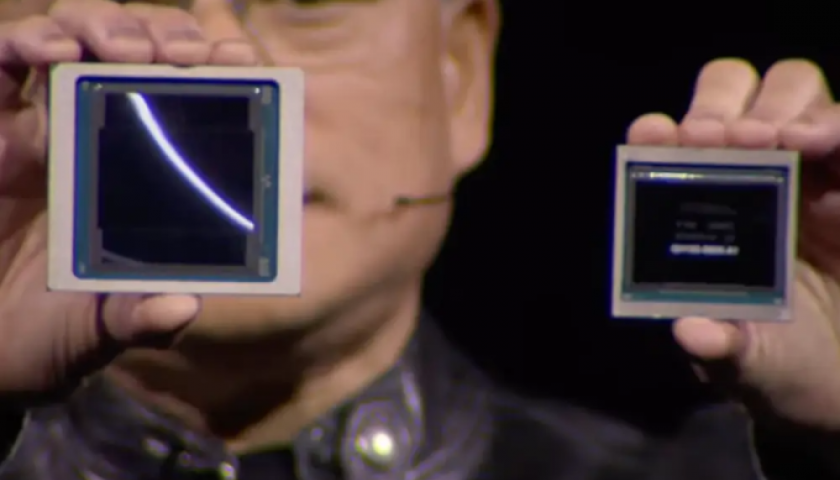

CEO Nvidia Jensen Huang cầm trên tay chip B200 (trái) và H100. Ảnh: Nvidia

"Blackwell nhanh hơn Hopper, nhưng quan trọng là nó có khả năng tính toán trong mạng, yếu tố giúp tốc độ xử lý AI nhanh hơn nữa cũng như thực hiện những công việc khó khăn trước đây, như biến lời nói thành video 3D", CEO Nvidia Jensen Huang nói tại sự kiện GPU Technology Conference - GTC 2024 của công ty ở San Jose, California rạng sáng 19/3 (giờ Hà Nội).

Blackwell có 208 tỷ bóng bán dẫn, cao gấp đôi so với 80 tỷ trên chip H100, có năng lực xử lý AI đạt 20 petaflop (20 triệu tỷ phép tính mỗi giây), gấp năm lần mức 4 petaflop của H100. Theo Nvidia, trên thực tế, Blackwell xử lý tác vụ nhanh gấp 7-30 lần H100, đồng thời giảm 25 lần chi phí cũng như mức tiêu thụ năng lượng.

CEO Nvidia lấy ví dụ, trước đây việc huấn luyện một mô hình AI 1.800 tham số cần đến 8.000 GPU và 15 megawatt điện. Giờ đây, 2.000 GPU B200 có thể thực hiện khối lượng công việc tương tự với lượng điện năng chỉ 4 megawatt.

Một trong những cải tiến then chốt là hệ thống Transformer Engine thế hệ hai nhân đôi khả năng tính toán, băng thông và kích thước mô hình. Khi kết hợp bộ chuyển mạch NVLink, hệ thống có thể hỗ trợ tối đa 576 GPU giao tiếp với nhau, với băng thông hai chiều 1,8 Tb/giây.

Chip Nvidia B200. Ảnh: Nvidia

"Không có vấn đề về bộ nhớ, cũng không có vấn đề về bộ nhớ đệm. Đơn giản Blackwell là chip khổng lồ. Tham vọng của nó là vượt lên giới hạn của vật lý", Huang cho biết. "GPU Blackwell là động cơ thúc đẩy cuộc cách mạng công nghiệp AI mới, sẽ hiện thực hóa lời hứa về AI cho mọi ngành công nghiệp".

Huang chưa công bố giá cho B200. Trước đó, chip H100 có giá 30.000-40.000 USD. Hãng cũng hướng tới khách hàng mua số lượng lớn bằng cách đóng gói nhiều chip vào một thiết kế duy nhất, gọi là GB200 NVL72. Gói chứa 72 chip AI, 36 bộ xử lý trung tâm, 600.000 bộ phận và nặng 1.361 kg. CEO Nvidia cũng tiết lộ Amazon, Google, Microsoft và Oracle sẽ dùng GB200 NVL72 cho trung tâm dữ liệu của mình.

Cùng với phần cứng, Nvidia cũng giới thiệu công cụ phần mềm mới, được gọi là Microservice. Bộ công cụ này giúp cải thiện hiệu quả hệ thống cho nhiều mục đích sử dụng khác nhau, giúp doanh nghiệp dễ dàng kết hợp mô hình AI vào công việc hơn, giống như một hệ điều hành máy tính tốt có thể giúp ứng dụng hoạt động tốt.

Ngoài ra, tại GTC 2024, Nvidia ra mắt nền tảng nghiên cứu dựa trên đám mây, sử dụng AI để nghiên cứu và thử nghiệm 6G. Hệ thống sẽ bao gồm một ứng dụng mô phỏng các môi trường như tháp di động đơn lẻ hoặc toàn bộ thành phố, cho phép nhà nghiên cứu và tổ chức thử nghiệm mạng 6G theo thời gian thực mà không cần phải lắp đặt trong thực tế. Các đơn vị đầu tiên tham gia có Nokia, Ansys, Samsung, SoftBank và Đại học Boston.

Theo vnexpress.net

Tin cùng chuyên mục

- Khắc phục sự cố không đăng nhập được VNeID trên thiết bị mới 01.04.2025 | 11:10 AM

- Toàn văn: Nghị quyết số 57-NQ/TW về đột phá phát triển khoa học, công nghệ, đổi mới sáng tạo và chuyển đổi số quốc gia 13.01.2025 | 10:08 AM

- Quyết tâm chuyển đổi số sâu rộng, toàn diện, thực chất, hiệu quả 17.10.2024 | 15:31 PM

- Sóng nhiệt kỷ lục ở Nam cực đe dọa tương lai Trái đất 06.08.2024 | 09:46 AM

- 201 thí sinh tham gia Hội thi tin học trẻ tỉnh Thái Bình năm 2024 10.06.2024 | 19:17 PM

- Tổng kết và trao giải hội thi, cuộc thi sáng tạo khoa học năm 2022 - 2023 18.12.2023 | 16:35 PM

- Hội thảo khoa học về vai trò của khoa học và công nghệ trong việc sản xuất, tiêu thụ và phát triển sản phẩm nông nghiệp 16.12.2023 | 14:38 PM

- Hội nghị khoa học về chẩn đoán và điều trị bệnh lý tim mạch 28.10.2023 | 12:02 PM

- Ứng dụng công nghệ sinh học trong sản xuất nước mắm 15.02.2023 | 18:51 PM

- Tàu container lớn nhất thế giới 13.02.2023 | 08:42 AM

Xem tin theo ngày

-

Đặc sắc chương trình nghệ thuật kỷ niệm 110 năm ngày sinh Tổng Bí thư Nguyễn Văn Linh và chào mừng hợp nhất tỉnh Hưng Yên và tỉnh Thái Bình

Đặc sắc chương trình nghệ thuật kỷ niệm 110 năm ngày sinh Tổng Bí thư Nguyễn Văn Linh và chào mừng hợp nhất tỉnh Hưng Yên và tỉnh Thái Bình

- Chủ tịch Ủy ban Trung ương MTTQ Việt Nam Đỗ Văn Chiến thăm làm việc tại phường Phố Hiến

- Công bố nghị quyết, quyết định của Trung ương, địa phương về sáp nhập đơn vị hành chính cấp tỉnh, cấp xã và kết thúc hoạt động cấp huyện

- Báo Thái Bình - Một hành trình với những mốc son lịch sử

- Thư tòa soạn

- Công bố quyết định của Bộ trưởng Bộ Công an, Giám đốc Công an tỉnh về công tác tổ chức, cán bộ

- Khởi công dự án nhà máy đốt chất thải rắn phát điện công nghệ hiện đại tại xã Thụy Trình

- Khởi công dự án đầu tư xây dựng sân golf Cồn Vành và dự án đầu tư xây dựng khu bến cảng hàng lỏng Ba Lạt

- Việt Nam nâng tầm vị thế tại Hội nghị quốc tế về biển và đại dương

- Hội thảo khoa học: Đồng chí Nguyễn Văn Linh – Nhà lãnh đạo kiên định, sáng tạo của Đảng và cách mạng Việt Nam