Siêu trí tuệ nhân tạo AGI là gì?

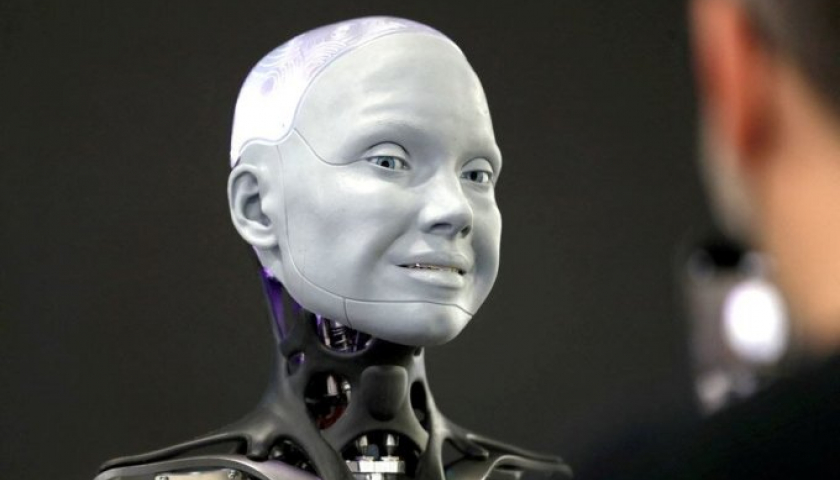

Một mẫu robot hình người. Ảnh: Reuters

Tháng 6/1956, một nhóm nhà khoa học và toán học từ khắp nước Mỹ tụ họp tại Đại học Dartmouth. Họ lên tầng cao nhất của khoa toán, tranh luận về một chủ đề mới đến mức khi đó còn chưa có tên gọi.

"Họ không thống nhất được việc nó thực sự là gì, thực hiện nó thế nào, hay gọi nó ra sao", Grace Solomonoff, góa phụ của một trong những nhà khoa học, kể lại trên Smithsonianmag. Những gì các chuyên gia đang bàn là làm sao tạo ra được một "cỗ máy biết nghĩ".

Hội thảo Dartmouth là một trong những khởi đầu của công cuộc tìm kiếm kéo dài hàng thập kỷ về trí thông minh nhân tạo. Trước đó, từ 1948, Alan Turing, cha đẻ ngành khoa học máy tính, cũng dự đoán về sự hình thành của AI toàn năng, có thể tư duy, học hỏi tương tự con người.

Trong hàng chục năm qua, hầu hết giải pháp được các nhà nghiên cứu đưa ra theo hướng AI hẹp (Narrow AI), chuyên thực hiện những nhiệm vụ riêng. Ví dụ, tổ chức tài chính dùng AI để dự đoán thị trường chứng khoán. Google đưa AI vào chẩn đoán bệnh tim. Người dùng sử dụng ChatGPT để làm văn, viết thơ, dùng Dall-E để vẽ tranh.

Tuy nhiên, thứ mà các nhà khoa học hướng tới là trí tuệ nhân tạo tổng quát AGI (Artificial General Intelligence) - những cỗ máy có khả năng tư duy như loài người. Khái niệm này được nhà vật lý người Mỹ Mark Gubrud đề cập trong các thảo luận về chủ đề tự động hóa từ 1997.

Hiện nay AGI chưa xuất hiện, nên được các nguồn định nghĩa khác nhau, nhưng hiểu chung là một dạng "siêu trí tuệ", thông thạo đa dạng lĩnh vực và làm được mọi việc.

Tại sự kiện TED AI ngày 17/10 ở San Francisco, Ilya Sutskever, nhà khoa học trưởng của OpenAI, mô tả AGI có thể hiểu và đọc dữ liệu từ nhiều nguồn riêng biệt. Khi tích lũy đủ kiến thức, hệ thống này thậm chí thông minh hơn con người. Nó cũng biết tận dụng khả năng tự huấn luyện để tạo thêm những AGI mới, ưu việt hơn thế hệ cũ.

Còn theo Ian Hogarth, chuyên gia AI của chính phủ Anh, AGI biết sáng tạo, phát triển một cách tự chủ và ý thức được sự tồn tại của bản thân. "AGI hiểu ngữ cảnh giao tiếp mà không cần cung cấp thêm gợi ý. Chúng sẽ trở thành một thế lực nằm ngoài tầm kiểm soát và hiểu biết của chúng ta", ông nói.

AGI đang được phát triển đến đâu?

"Tôi từng nghĩ phải 20-50 năm tới con người mới đạt được AGI, nhưng giờ mọi thứ thay đổi quá nhanh. Vấn đề của chúng ta là tìm ra cách kiểm soát chúng", Geoffrey Hinton, giáo sư đoạt giải Turing - giải thưởng cao nhất về khoa học máy tính, nói với CBS News vào tháng 3.

Đến tháng 5, sau hơn 10 năm cống hiến cho Google, ông bất ngờ từ chức để có thể công khai cảnh báo về sự nguy hiểm của công nghệ mới. Ông tin cuộc đua của Microsoft, Google và một số công ty công nghệ sẽ nhanh chóng leo thang thành cuộc đua toàn cầu mà không bị kiểm soát bởi bất kỳ quy định nào. AI có thể bị chi phối bởi số ít tập đoàn và chính phủ, dẫn đến bị "vũ khí hóa" nhằm phục vụ mục đích xấu.

Cũng trong tháng 5, Microsoft Research nhận định GPT-4 của OpenAI đã tiến gần hơn đến mô hình AGI.

Ngày 16/11 tại Diễn đàn Hợp tác Kinh tế châu Á - Thái Bình Dương (APEC) ở San Francisco, Sam Altman, CEO OpenAI, phát biểu: "Trong bốn lần tạo nên lịch sử tại OpenAI, lần gần nhất chỉ mới cách đây vài tuần. Tôi đã có mặt trong phòng. Chúng tôi gần như đã đẩy lùi bức màn tối phía trước và mở ra biên giới khám phá mới. Làm được điều đó là vinh dự nghề nghiệp của một đời".

Altman không mô tả chi tiết về bước đột phá mà ông nhắc đến, nhưng một ngày sau, ông bất ngờ bị sa thải. Nguyên nhân chưa được công bố, nhưng Reuters dẫn nguồn nội bộ cho biết nguồn cơn là một lá thư mật do các nhà nghiên cứu trong công ty gửi đến hội đồng quản trị, cảnh báo về dự án Q* (Q-Star).

Q* được cho là một một dạng AGI sơ khai, được OpenAI phát triển song song với ChatGPT. Bức thư đề cập đến "mối nguy hiểm và sức mạnh tiềm tàng" mà Q* có thể gây ra. Một nguồn tin cho biết thuật toán trên Q* đã "vượt qua môn toán cấp phổ thông". Hiện các mô hình AI rất giỏi viết và dịch ngôn ngữ, nhưng cũng đưa ra nhiều câu trả lời khác nhau cho cùng một câu hỏi. Tùy vào nguồn dữ liệu được đào tạo, nó có thể bịa đặt và không phải lúc nào câu trả lời cũng đúng. Nhưng với năng lực hiểu biết toán học cao cấp, AI có thể tính toán và đưa ra một câu trả lời đúng và duy nhất, tức có khả năng suy luận tốt hơn, gần giống trí thông minh của con người.

Trên mạng xã hội X, tỷ phú Elon Musk cũng đặt nghi vấn OpenAI có thể đang phát triển "điều gì đó đáng sợ". "Thế giới cần biết nếu OpenAI sở hữu thứ gì đó gây nguy hiểm cho nhân loại", ông nói ngày 20/11.

Nỗi lo về siêu trí tuệ AGI

Khi từ chức hồi tháng 5, giáo sư Hinton lo ngại AI sẽ trở thành mối đe dọa cho nền văn minh nhân loại khi có thể xử lý lượng dữ liệu khổng lồ và liên tục học hỏi. "Khi chúng bắt đầu viết code và chạy dòng mã của riêng mình, những con robot sát thủ sẽ xuất hiện ngoài đời thực", ông cho hay.

"Tôi lo lắng trước viễn cảnh thế giới tràn ngập những robot không cảm xúc. Nó có thể là một thảm họa", giáo sư triết học David Chalmers tại Đại học New York nói từ năm 2019.

Nhiều người nổi tiếng như nhà vật lý học Stephen Hawking, tỷ phú Elon Musk cũng từng cảnh báo nguy cơ AI hủy hoại hành tinh. "Trí tuệ nhân tạo có thể là điều tồi tệ nhất của lịch sử nhân loại. Sớm muộn chúng sẽ không thể bị kiểm soát", Hawking nhiều lần khuyến cáo khi còn sống.

"Tôi thực sự tiếp xúc rất gần với những công nghệ mới của AI. Điều này khiến tôi khiếp sợ", Musk từng viết trên X. "Hãy nhớ lời tôi: AI nguy hiểm hơn vũ khí hạt nhân nhiều".

Nhằm hạn chế nguy cơ từ AI, một số quốc gia đang thông qua quy định quản lý, gồm phát triển AI có trách nhiệm. Trong khi đó, cũng có những chuyên gia lại nhận định AGI còn lâu mới xuất hiện để có thể gây hại cho nhân loại.

"AI vẫn có những thiếu sót lớn, những mô hình như ChatGPT không thông minh hơn con người, thậm chí còn không thông minh bằng một con chó", Yann Lecun, Giám đốc AI tại Meta, nói tại sự kiện Viva Tech ở Paris vào tháng 6.

Nhiều nhà nghiên cứu cho rằng viễn cảnh thiên đường hay địa ngục từ AGI đều rất khó diễn ra. Thế giới sẽ không xây dựng AI theo cách con người mơ ước hay lo sợ. Có nghĩa, AI chỉ đóng vai trò là một công cụ, tương tự lửa hay ngôn ngữ. Nó có mặt trái, thậm chí có thể gây thảm họa, nhưng lợi ích mà nó đem lại còn lớn hơn thế. Việc thiết kế và sử dụng nó như thế nào mới là quan trọng.

"AGI sẽ giải quyết bất kỳ nhiệm vụ nào của con người mà không bị giới hạn bởi cách chúng được thiết lập, ví dụ phát triển phương pháp chữa bệnh hay khám phá các dạng năng lượng tái tạo mới", Tom Everitt, nhà nghiên cứu an toàn AGI tại DeepMind, bộ phận AI của Google, cho biết.

Còn theo Jacques Attali, chuyên gia kinh tế, xã hội người Pháp, siêu AI trở nên tốt hay xấu phụ thuộc vào lựa chọn của con người. "Nếu dùng AI để phát triển vũ khí, kết quả sẽ rất khủng khiếp. Ngược lại, AI ứng dụng cho sức khỏe, giáo dục, văn hóa sẽ mang đến điều tuyệt vời", ông nói.

Theo vnexpress.net

Tin cùng chuyên mục

- Nokia chuẩn bị triển khai 5G tại Việt Nam 24.09.2024 | 13:58 PM

- Sinh động các chương trình trực tiếp tại Fanpage Báo Tuyên Quang online 03.01.2023 | 08:16 AM

- Thực hiện quy định về chuẩn hóa thông tin thuê bao di động 31.03.2023 | 16:13 PM

- Hưởng ứng ngày Chuyển đổi số quốc gia 10/10Chuyển đổi số vì một cuộc sống tốt đẹp hơn 09.10.2022 | 21:42 PM

- Sở Thông tin và Truyền thông: Diễn tập ứng phó sự cố an toàn thông tin mạng năm 2022 04.10.2022 | 17:30 PM

- Hướng dẫn trẻ em sử dụng mạng internet an toàn và hiệu quả 05.08.2022 | 08:27 AM

- Người dùng nên cập nhật Chrome 92 ngay để vá 9 lỗ hổng nghiêm trọng 21.08.2021 | 15:47 PM

- UBND tỉnh nghe báo cáo dự thảo đề án chuyển đổi số tỉnh Thái Bình giai đoạn 2021 - 2025, định hướng đến năm 2030 21.07.2021 | 19:16 PM

- Thiết bị đầu tiên chuyển suy nghĩ thành câu nói 19.07.2021 | 09:47 AM

- Tại sao không gộp các ứng dụng chống dịch thành một 'super app' 19.07.2021 | 09:48 AM

Xem tin theo ngày

-

Thống nhất nội dung, chương trình kỳ họp để giải quyết công việc phát sinh đột xuất và kỳ họp thứ mười của HĐND tỉnh

Thống nhất nội dung, chương trình kỳ họp để giải quyết công việc phát sinh đột xuất và kỳ họp thứ mười của HĐND tỉnh

- Chủ tịch nước Lương Cường làm việc với Tỉnh ủy Hưng Yên và Tỉnh ủy Thái Bình về thực hiện Nghị quyết Hội nghị lần thứ 11 Ban Chấp hành Trung ương Đảng khóa XIII

- Đồng chí Bí thư Tỉnh ủy kiểm tra công tác sắp xếp đơn vị hành chính cấp xã tại huyện Đông Hưng

- Thống nhất phương án thành lập Đảng bộ tỉnh Hưng Yên (mới)

- Thường trực Tỉnh ủy làm việc với Sở Khoa học và Công nghệ

- Sơ kết công tác mặt trận 6 tháng đầu năm

- Đổi mới và nâng cao chất lượng sinh hoạt chi bộ trong giai đoạn mới

- Bảo đảm tiến độ, yêu cầu theo các nghị quyết, kết luận của Trung ương, Bộ Chính trị, Ban Bí thư

- Tập trung bàn các giải pháp thúc đẩy phát triển nhà ở xã hội

- Bảo đảm hệ điều kiện tốt nhất cho kỳ thi tuyển sinh vào lớp 10 THPT năm học 2025 - 2026